Los A/B testing son experimentos estadísticos para validar las hipótesis de conversión. Una muestra se divide en dos y se aplica una variable en la prueba para determinar cuál tiene mejor rendimiento, ya sea un botón call-to-action, una imagen o un texto.

Si alguna vez sospechaste que un cambio en el sitio web del hotel, un anuncio pago o email podrían aumentar la tasa de conversión de las ventas. Es solo a través de una A/B testing que estarás seguro.

Puedes utilizar como muestra a un número X de usuarios del sitio web del hotel, del que tengas emails o el público objetivo de una campaña de marketing hotelero.

Para que un A/B testing funcione, necesitas:

- un objetivo claro,

- una muestra mínima,

- una variación significativa.

El objetivo del A/B testing es aumentar una conversión específica, ya sea más tráfico, clics, etc.

Puedes empezar experimentando con pequeñas cosas como cambiar el color o la posición de un botón, el orden y el resaltado de los elementos de la página, por ejemplo: ¿será que llevando al principio de la página el sello TripAdvisor Best Hotel aumentarán mis conversiones? O incluso ocultando elementos.

Esta es una prueba de hipótesis, que puede resultar ser correcta o incorrecta. Digamos que te parece que cambiar el color del CTA llamará más la atención y tendrá más clics. Sin embargo no estarás seguro hasta que lo pruebes.

Recuerda que esta prueba normalmente no se basa en averiguar qué elemento funciona mejor y repetirlo en otras páginas. Pues, lo que funciona en un lugar, con un objetivo, puede no funcionar en un contexto diferente. Por ejemplo:

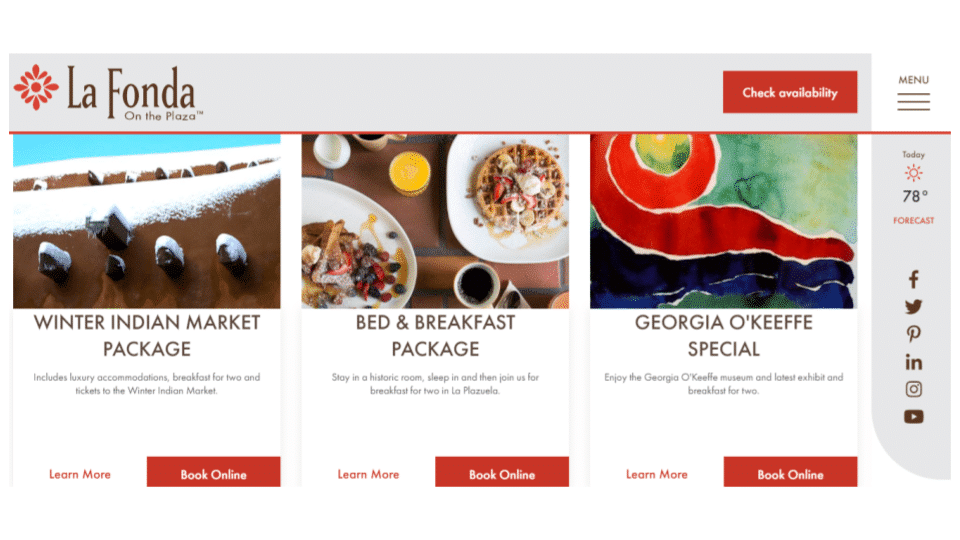

El menú fijo tiene el botón «Comprobar disponibilidad», pero debajo de los CTA están las «Reservas en línea», específicas para ofertas y paquetes especiales.

Para hacer A/B testing, debes tener en cuenta que incluso las ideas más brillantes pueden resultar ineficientes e incluso disminuir las conversiones.

Muestra mínima para un A/B testing

No siempre el resultado con el mayor porcentaje de conversión en un A/B testing es el ganador. Por ejemplo, tienes dos botones de diferentes colores y el CTR final de A es 10.5% y el de B es 5%.

El botón A es el ganador solo si la muestra tiene un tamaño mínimo para que el resultado sea relevante. De lo contrario, este porcentaje puede estar indicando simplemente la diferencia de uno o dos clics.

Hay varias calculadoras del tamaño de muestras por Internet. Una muy simple es la de Survey Monkey. Esta tiene en cuenta el tamaño de la población, el nivel de confianza y el margen de error en la estadística significativa.

Estadística significativa: en el cálculo de un A/B testing es el nivel de tolerancia y confianza en el resultado. Generalmente cuando se aplica en el 95%, significa que las posibilidades de que el resultado sea correcto y no puramente aleatorio, es del 95%. Por otro lado, hay un 5% de posibilidades de que esté equivocado.

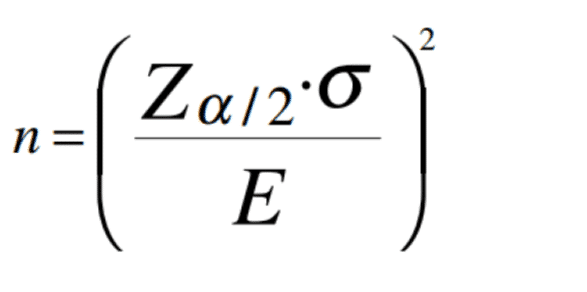

Estas calculadoras hacen la cuenta matemática de un A/B testing por ti. La ecuación no es simple, por lo que es mejor tener ¡una herramienta que la haga por ti!

Fuente: Conectado Marketing Digital

En resumen, la letra n corresponde al tamaño mínimo de la muestra. Z es la estadística significativa asignada. E es el margen de error. σ es la desviación estándar, es decir, la variabilidad estimada para la prueba.

Pero no te preocupes por este nivel de complejidad. La mayoría de las pruebas A/B en el negocio hotelero son bastante simples. Según Diogo Franco, consultor de marketing de hoteles con una década de experiencia en la industria, el 5% es un buen margen de consideración, pero también dependerá de tu base de datos.

«Si tu base es de 30.000 usuarios, una diferencia del 5% es muy representativa, por lo que el 2,5% ya es suficiente».

Preocúpate de hacer pruebas con muestras grandes primero. Dependiendo del resultado, replica la prueba con una muestra más pequeña para estar seguro.

A/B testing en la práctica para los hoteles

Como hemos dicho, la variable de prueba puede ser un botón, en cualquier página del sitio, e-mail y campaña. Generalmente, el CTA que los hoteleros quieren destacar más, es el botón «Reserva Ahora».

Puedes hacer pruebas para determinar el mejor texto para ese CTA, puede ser «Reserva Ahora» u otra variable, como «Ver disponibilidad«, «Consultar tarifas«, «Ver precios» y así sucesivamente.

«Otra cosa que hay que tener en cuenta es que el CTA para los hoteles de negocios funciona de manera diferente al de los hoteles de ocio», explica Diogo, que da el ejemplo del botón «Ver precios ahora» que funciona mejor para los hoteles de ocio.

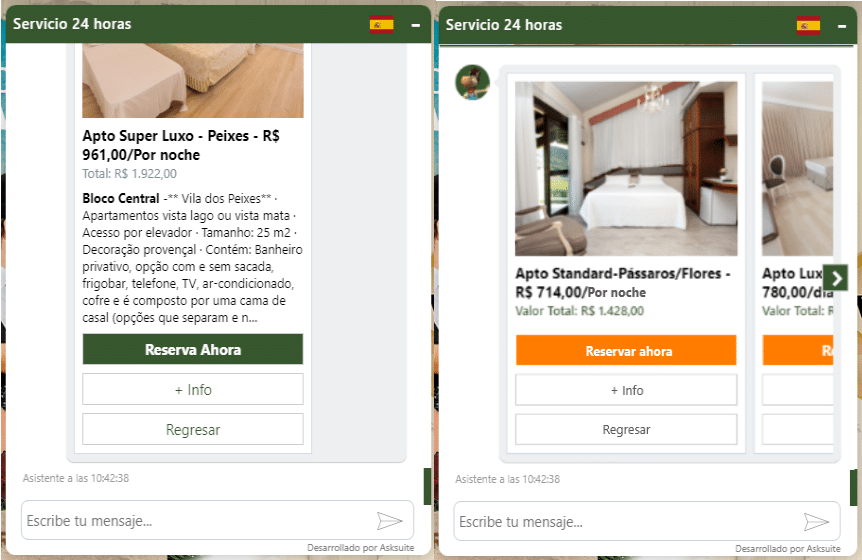

En Asksuite, hemos hecho una serie de A/B testing para aumentar las conversiones de ventas en nuestros chats con clientes. Ya hemos probado cambiar el color del botón «Reservar Ahora» y disminuir la cantidad de texto que se muestra.

A/B testing en el chat de servicio automático de Asksuite en la web del hotel Fazzenda Park

En el servicio de chat, después de la solicitud de cotización, los resultados aparecen en una lista carrusel, mostrando las habitaciones disponibles, la tarifa diaria y el valor total de los días que el cliente será alojado.

La intención de la prueba era determinar si el texto de la descripción de la habitación era necesario o si solo distanciaba al usuario del botón «Reservar ahora». Ocultar la descripción no sería un problema, ya que el viajero que quiera más información podría hacer clic en +Info. Era una buena hipótesis, pero en la práctica no presentaba ninguna variación.

En los A/B testing, es normal probar varias hipótesis hasta que una sea correcta. Lo hicimos bien cuando cambiamos el mensaje del ícono del chat.

Arriba está el chatbot de la página principal del Costão do Santinho Resort. El texto por defecto de todos los chatbots es «Estamos en línea las 24 horas«. Luego cambiamos a «¡El mejor precio aquí!» y lo pusimos a prueba.

Resultado: ¡hubo aproximadamente un 30% más de interacciones con el robot y el mismo aumento de clics en «Reservar ahora»!

Conclusión

Diogo Franco explica que varios factores afectan a un A/B testing, además de un CTA. Puede ser el tiempo de carga del sitio, la usabilidad y la capacidad de respuesta, la latencia del servidor y muchas otras variables que influyen en la tasa de conversión de las ventas.

No es necesario probar todas estas variables, ya que muchos estudios, incluidos los de Google, demuestran que los sitios que se cargan lentamente, son evitados (alta tasa de rebote), por lo que las tasas de conversión son más bajas.

¿Te gustó el artículo? ¡Compártelo y déjanos tu comentario!